19 mei 2025

Israël gebruikt AI voor aanvallen in Gaza: van 50 doelwitten per jaar naar 100 per dag

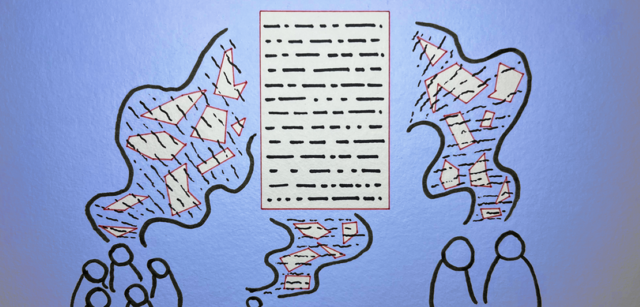

Volgens een artikel in Het Parool maakt Israël gebruik van kunstmatige intelligentie (AI) om sneller, preciezer en vaker doelwitten aan te wijzen in Gaza. Dit heeft geleid tot een enorme toename van het aantal aangevallen doelen, met ernstige gevolgen voor burgers.

Sinds de inzet van kunstmatige intelligentie (AI) bij militaire operaties in Gaza kan het Israëlische leger aanzienlijk meer doelwitten identificeren en aanvallen. Voor de introductie van AI wist het leger jaarlijks zo’n vijftig doelwitten vast te stellen. Nu zijn dat er dagelijks ongeveer honderd, zegt Jessica Dorsey, universitair docent internationaal recht aan de Universiteit Utrecht.

Volgens Dorsey worden doelwitten geselecteerd op basis van een puntensysteem, waarbij bijvoorbeeld mannen een hogere score krijgen dan vrouwen. Andere factoren, zoals telefoongesprekken met vermeende Hamasstrijders of deelname aan verdachte WhatsApp-groepen, kunnen ook meetellen. Dit systeem is echter omstreden, omdat het onduidelijk blijft op basis van welke criteria mensen op de doelwittenlijst terechtkomen.

Het Israëlische leger gebruikt verschillende AI-systemen, waaronder Habsora, Lavender, de Alchemist en Where’s Daddy. Deze systemen werken samen om potentiële doelwitten te identificeren en te bepalen hoeveel munitie nodig is om ze uit te schakelen. Ondanks de belofte van precisie leidt de inzet van AI juist tot meer verwoesting, zegt Dorsey. Volgens het ministerie van Gezondheid in Gaza zijn er al meer dan 50.000 slachtoffers gevallen, waaronder veel kinderen.

Dorsey benadrukt dat AI in oorlogssituaties altijd moet worden toegepast volgens het mens-machine-mens-principe: een mens neemt het initiatief, AI ondersteunt, en een mens neemt de eindbeslissing. Maar in de praktijk wordt dit principe niet strikt nageleefd door het Israëlische leger. Zo krijgen militaire operators soms slechts twintig seconden om een doelwit te valideren, wat volgens Dorsey onvoldoende is voor zorgvuldige besluitvorming.

Volgens Dorsey weerspiegelt AI altijd de vooroordelen van degenen die het ontwikkelen en trainen. In dit geval leidt dat ertoe dat de systemen een eenzijdig beeld van de vijand creëren. “AI in handen van de verkeerde partij die het oorlogsrecht niet respecteert, is vooral een effectieve moordmachine,” waarschuwt ze.

Vergelijkbaar >

Vergelijkbare nieuwsitems

22 augustus

AI schrijft beter fantasyverhaal dan bestsellerauteurs

Lees meer >

22 augustus

Artsen worden minder scherp door AI bij kijkonderzoek

Lees meer >

22 augustus

AI helpt bij diverser nieuwsaanbod en gezonder debat

Lees meer >